发布会刚开始,大家都很奇怪,本来说的「天花乱坠」,让大家「期待十足」,怎么着也得弄个GPT5吧?这4o是几个意思?

没想到,GPT-4o的o翻译过来,居然是“Omni”,按照字面意思来理解的话,就是“全知全能”。

好家伙,直接明确了OpenAI对于这一次更新的期盼值有多高了。

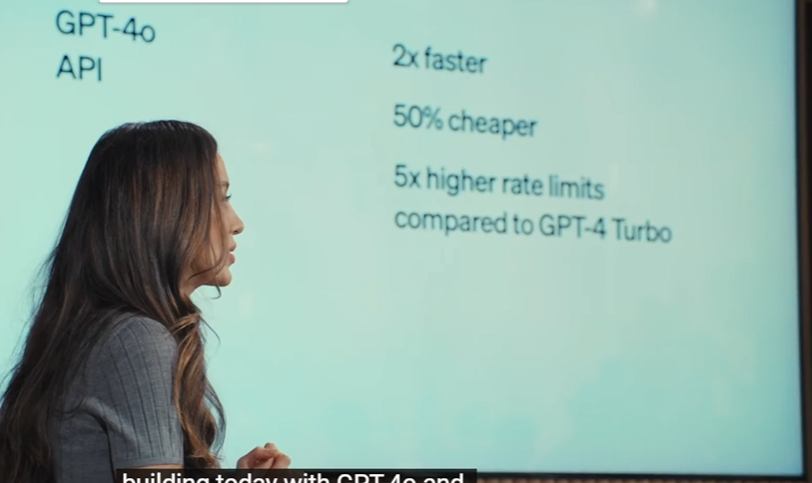

发布会刚开始,米拉·穆拉蒂就上台阐述了自己的“野心”,并说明:OpenAI的目标是进一步减小人们使用AI的障碍,让所有人都能在工作、学习、创造中用上AI工具。

而为了达成这个目的,OpenAI一共做了三件事:公平,公平,还是挺忙的公平… 发布更强大的模型GPT-4o,更新用户界面提高使用体验,然后一口气免费开放给用户。

什么?免费??居然免费??

当然,虽然免费了,却依然有“付费模式”可选,而一旦你选择了付费模式,你就会「立享尊贵的5倍信息流限制」。也就是说,免费用户能和GPT-4o说话的次数x5,就是尊贵的“会员权限”了。(没理解错吧!)

更加快了!

如果你用了4o的,第一感觉就是快!太快了!

此前GPT-3.5语音对话的平均延迟为2.8秒、GPT-4为5.4秒,音频在输入时还会由于处理方式丢失大量信息,无法识别笑声、歌唱声和情感表达等。

而GPT-4o可以在232毫秒内对音频输入做出反应,甚至还能随意打断,与人类在对话中的反应时间相近,彻底颠覆了以往的“语音助手”。

啥意思呢?它要比你所有的大模型都要快,就是说你吵不过AI了!

更像人了!

快只是“开胃小菜”,GPT-4o还改进了GPT在文本、视觉以及音频方面的能力。并且它能以平均320毫秒,做出响应。

听起来挺“硬”,但实际上,就是GPT-4o的所有表述更像是“人类”了,并且能够通过你的语音,分析你的语气进行“察言观色”,并且实时推理,给你一个绝对正确且满足你情绪的答案。

而且,在和GPT-4o对话的时候,你可以无视环境,无视语序,随时插嘴,粗暴打断。

在这种情况下,模型也能够进行实时响应,对你在任何时间所说的任何话做出一个明确合理的回答。

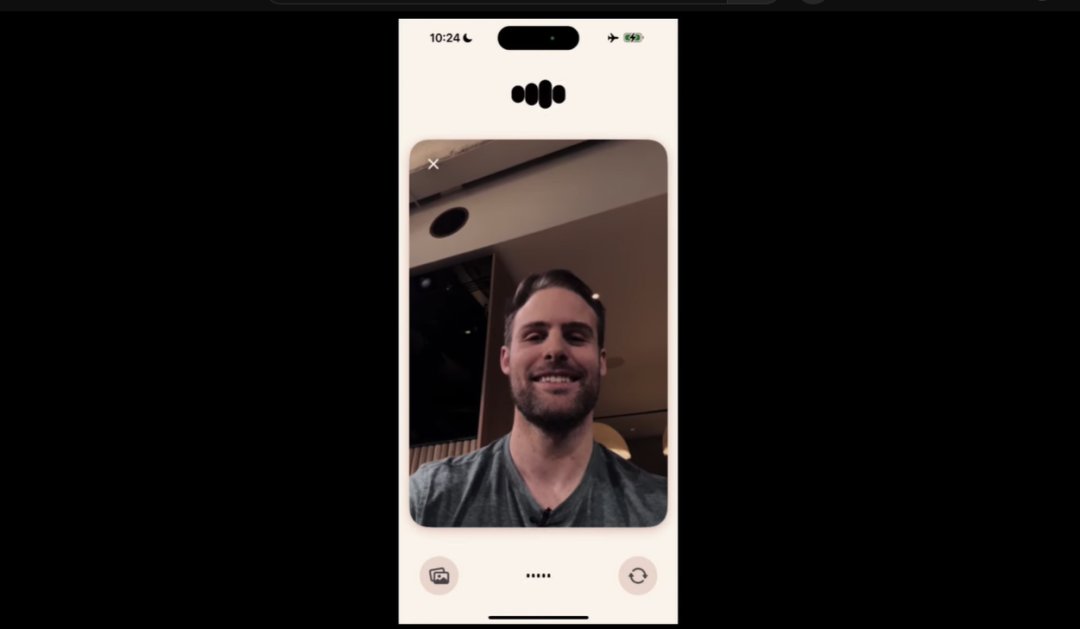

比如,在研发负责人Mark Chen向模型说明自己在台上很紧张时,GPT-4o给出的回复是:你在台上做演示吗,你很棒哦!深呼吸一下,你可是个专家!

而当Mark Chen真的猛烈呼吸了几下之后,GPT-4o也准确的抓住了这点,回复到:放松啊Mark,你可不是个吸尘器。

神了啊,神了,我哥们儿都没这么能察言观色!

GPT-4o还能够“用自己的情绪讲故事”。简单来说,就是你可以指定它的语气,让它变得更加情绪化,更有戏剧性,甚至还能要求它模仿机器人和唱歌的声音的声音!

最后,当现场在纸上写下“我爱GPT”后,GPT-4o在摄像头捕捉到之后,居然发出了一声“尖叫”,然后大声回答:你你你居然我爱我,你太可爱了!

…算是充分满足了老夫的少女心。这一波,情绪价值拉满!

更全能了!

GPT-4o的功能远不止于此。在发布会上,OpenAI团队讲述到:为了真正实现「让AGI惠及全人类」,我们的GPT-4o有50种语言的版本,并改进了推理的质量和速度。

这也就意味着,GPT-4o基本覆盖了全球的语言和地区!

而且 ,实时翻译也不在话下,现场也演示了手机可以拿来当翻译机去来回翻译西班牙语和英语。 试想一波,出国旅行带着 GPT 就像随身带着一个会所有语言的翻译一样,简直不要太爽。

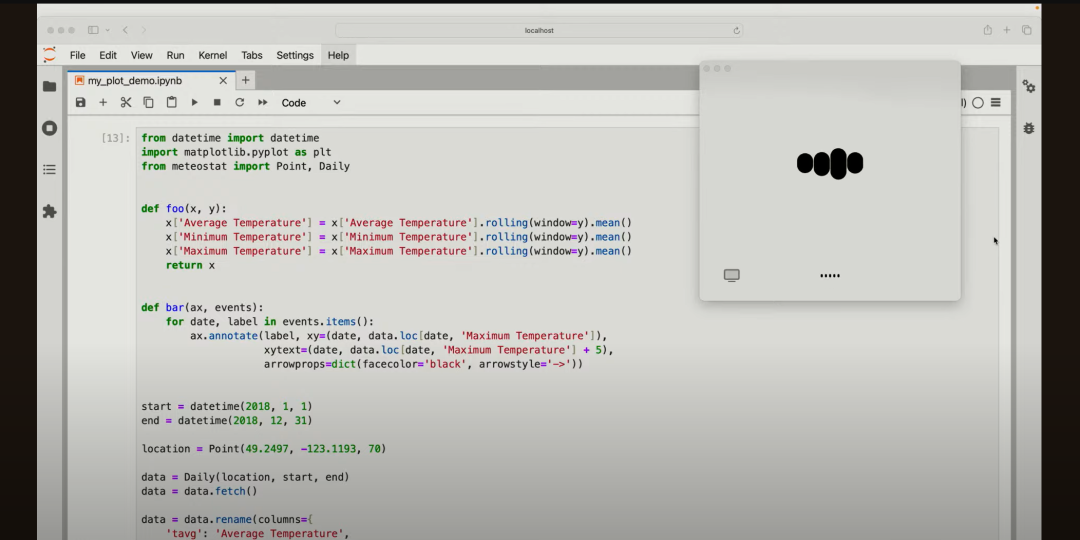

GPT-4o还可以打开摄像头,直接看屏幕,对着屏幕直接写代码。这个功能实在是太神了,就是不知道对于程序员来说“是不是一件好事”…

在视频交互方面,GPT-4o也「长了眼睛」:它可以直接打开摄像头,实时观察屏幕前的人在做什么。

比如现场研发负责人Barret手写了一个方程,并打开摄像头拍给GPT-4o,它能够一步一步地讲解出解题步骤,并且在解题的过程中,充分给出引导与鼓励。

行,比我老师强,她只会骂我(不是)。